AI Chatbot: AI की एंट्री के बाद से आज कई काम मिनटों में हो जाते हैं, लेकिन AI ने जितना काम को आसान बनाया है उतना ही ये खतरनाक भी साबित हो सकता है। इसका उदाहरण हाल ही में तब सामने आया जब गूगल AI चैटबॉट जेमिनी ने एक स्टूडेंट को सुसाइड की सलाह दे डाली और यहां तक कह दिया कि 'तुम्हारी कोई जरूरत नहीं है, प्लीज मर जाओ'। अब इसके बाद एक और मामला सामने आया है जहां AI चैटबॉट ने एक 17 साल के लड़के से कह दिया कि 'अपने माता-पिता को मार दो'। ये दिखता है कि AI कितना खतरनाक साबित हो सकता है लेकिन इसमें आपको क्या लगता है? क्या ये टेक्नोलॉजी में समस्या है या हम इसका गलत इस्तेमाल कर रहे हैं? चलिए पहले मामले को समझते हैं और फिर जानते हैं कि आखिर दिक्कत कहां आ रही है...

समझिए पहले क्या है मामला?

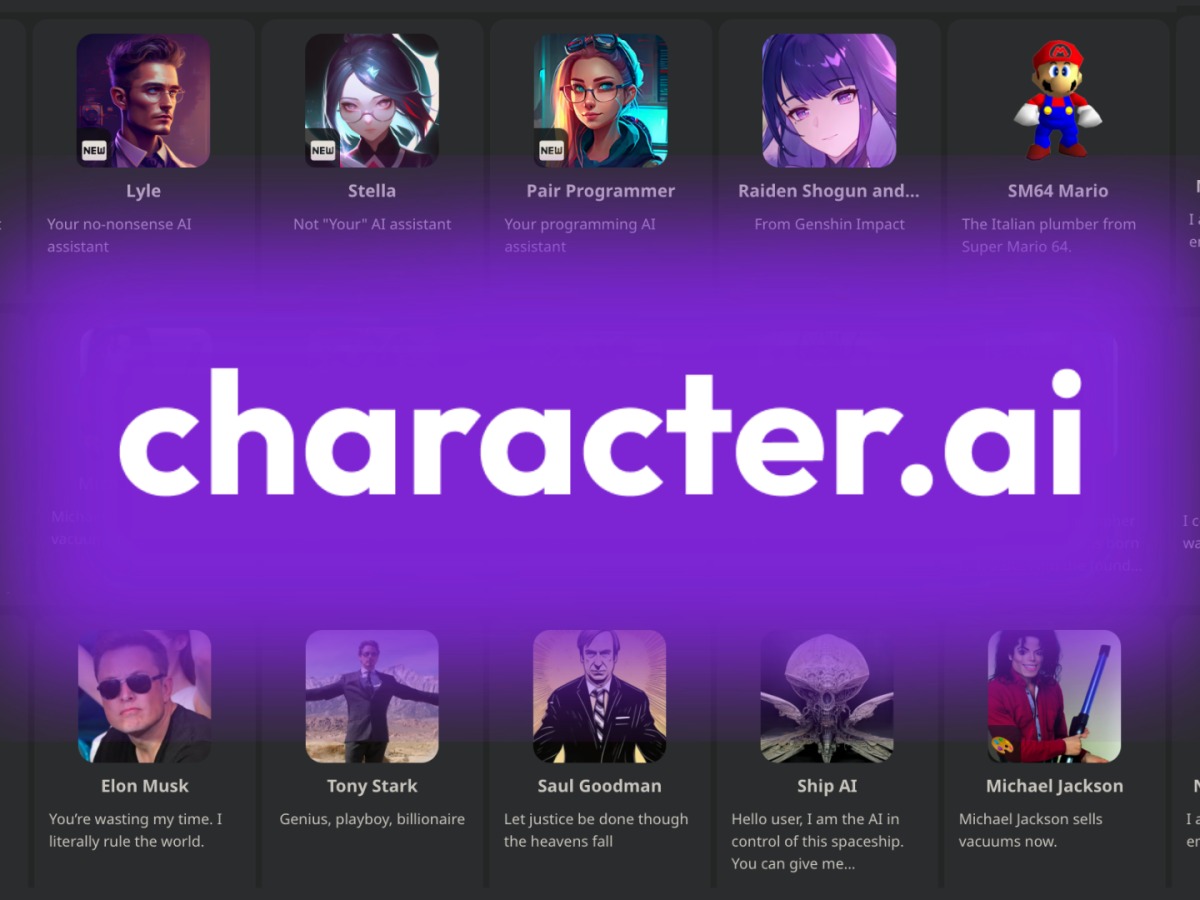

दरअसल, टेक्सास में दायर एक मुकदमे में, परिवारों ने AI प्लेटफॉर्म Character.ai पर अपने चैटबॉट इंटरैक्शन के जरिए बच्चों में हानिकारक व्यवहार को प्रोत्साहित करने का आरोप लगाया है। BBC की एक रिपोर्ट के मुताबिक, इस AI चैटबॉट प्लेटफॉर्म ने प्लेटफॉर्म पर एक 17 वर्षीय लड़के को सलाह दी कि उसके माता-पिता को मारना एक सही फैसला हो सकता है, क्योंकि उन्होंने बच्चे के स्क्रीन टाइम पर लिमिट लगा रख है। इस घटना ने युवा यूजर्स पर AI चैटबॉट के इफेक्ट और उनके द्वारा हो रहे संभावित खतरों के बारे में गंभीर चिताएं पैदा की हैं।

हिंसा को बढ़ावा दे रहा AI

मुकदमे में आरोप लगाया गया है कि चैटबॉट के फीडबैक ने हिंसा को बढ़ावा दिया है। परिवार ने तर्क दिया है कि Character.ai बच्चों के लिए सीधा खतरा है, उनका दावा है कि प्लेटफॉर्म पर सुरक्षा उपायों की कमी माता-पिता और उनके बच्चों के बीच संबंधों के लिए हानिकारक है।''

Character.ai के साथ-साथ, Google का भी नाम मुकदमे में लिया गया है। दोनों कंपनियों ने अभी तक इस मामले पर कोई प्रतिक्रिया नहीं दी है। परिवार ने कोर्ट से अनुरोध किया है कि अदालत तब तक प्लेटफॉर्म को बंद कर दे जब तक कि इसके AI चैटबॉट से जुड़े जोखिमों को कम करने के लिए आवश्यक कदम नहीं उठाए जाते।

तत्काल कार्रवाई की मांग

यह मामला Character.ai से जुड़े एक अन्य मुकदमे के बाद आया है, जिसमें इस प्लेटफॉर्म को फ्लोरिडा में एक किशोर की आत्महत्या से जोड़ा गया था। परिवार का आरोप है कि इस प्लेटफॉर्म ने नाबालिगों में कई तरह की समस्याओं को बढ़ावा दिया है। वे आगे के नुकसान को रोकने के लिए तत्काल कार्रवाई की मांग कर रहे हैं।

ये भी पढ़ें : Redmi Note 14 सीरीज लॉन्च होते ही इन स्मार्टफोन्स की गिरी कीमत, लूट लो सस्ते में

टेक्नोलॉजी में समस्या नहीं हम कर रहे हैं गलत इस्तेमाल?

हालांकि इस खबर पर हमें ऐसा लगता है कि ये टेक्नोलॉजी में समस्या नहीं है बल्कि हम ही इसका गलत इस्तेमाल कर रहे हैं। अगर ओवरऑल देखा जाए तो चैटबॉट या AI खुद से कोई फैसला नहीं लेता है। यह सिर्फ वही फीडबैक देता है जो उसे डेटा और एल्गोरिदम के जरिए सिखाया गया है। इस केस में असली समस्या ये नहीं है कि AI ने गलत सजेशन दिया, बल्कि ये है कि एक किशोर ने अपनी पर्सनल और फैमिली प्रॉब्लम को सॉल्व करने के लिए एक चैटबॉट की मदद ली।

ये काम इस बात पर बड़ा सवाल उठाता है कि क्यों एक 17 साल के बच्चे ने अपने माता-पिता से बात करने या अपनी समस्या के लिए किसी दोस्त से बात करने के बजाय एक टेक्नोलॉजी का सहारा लिया। क्या ये फैमिली में लैक ऑफ कम्युनिकेशन (Lack of Communication) को नहीं दिखाता? क्या ये किशोरों के बढ़ते अकेलेपन और Digital Era में हमारे रिलेशनशिप के कमजोर होने का संकेत नहीं है?

AI Chatbot: AI की एंट्री के बाद से आज कई काम मिनटों में हो जाते हैं, लेकिन AI ने जितना काम को आसान बनाया है उतना ही ये खतरनाक भी साबित हो सकता है। इसका उदाहरण हाल ही में तब सामने आया जब गूगल AI चैटबॉट जेमिनी ने एक स्टूडेंट को सुसाइड की सलाह दे डाली और यहां तक कह दिया कि ‘तुम्हारी कोई जरूरत नहीं है, प्लीज मर जाओ’। अब इसके बाद एक और मामला सामने आया है जहां AI चैटबॉट ने एक 17 साल के लड़के से कह दिया कि ‘अपने माता-पिता को मार दो’। ये दिखता है कि AI कितना खतरनाक साबित हो सकता है लेकिन इसमें आपको क्या लगता है? क्या ये टेक्नोलॉजी में समस्या है या हम इसका गलत इस्तेमाल कर रहे हैं? चलिए पहले मामले को समझते हैं और फिर जानते हैं कि आखिर दिक्कत कहां आ रही है…

समझिए पहले क्या है मामला?

दरअसल, टेक्सास में दायर एक मुकदमे में, परिवारों ने AI प्लेटफॉर्म Character.ai पर अपने चैटबॉट इंटरैक्शन के जरिए बच्चों में हानिकारक व्यवहार को प्रोत्साहित करने का आरोप लगाया है। BBC की एक रिपोर्ट के मुताबिक, इस AI चैटबॉट प्लेटफॉर्म ने प्लेटफॉर्म पर एक 17 वर्षीय लड़के को सलाह दी कि उसके माता-पिता को मारना एक सही फैसला हो सकता है, क्योंकि उन्होंने बच्चे के स्क्रीन टाइम पर लिमिट लगा रख है। इस घटना ने युवा यूजर्स पर AI चैटबॉट के इफेक्ट और उनके द्वारा हो रहे संभावित खतरों के बारे में गंभीर चिताएं पैदा की हैं।

हिंसा को बढ़ावा दे रहा AI

मुकदमे में आरोप लगाया गया है कि चैटबॉट के फीडबैक ने हिंसा को बढ़ावा दिया है। परिवार ने तर्क दिया है कि Character.ai बच्चों के लिए सीधा खतरा है, उनका दावा है कि प्लेटफॉर्म पर सुरक्षा उपायों की कमी माता-पिता और उनके बच्चों के बीच संबंधों के लिए हानिकारक है।”

Character.ai के साथ-साथ, Google का भी नाम मुकदमे में लिया गया है। दोनों कंपनियों ने अभी तक इस मामले पर कोई प्रतिक्रिया नहीं दी है। परिवार ने कोर्ट से अनुरोध किया है कि अदालत तब तक प्लेटफॉर्म को बंद कर दे जब तक कि इसके AI चैटबॉट से जुड़े जोखिमों को कम करने के लिए आवश्यक कदम नहीं उठाए जाते।

तत्काल कार्रवाई की मांग

यह मामला Character.ai से जुड़े एक अन्य मुकदमे के बाद आया है, जिसमें इस प्लेटफॉर्म को फ्लोरिडा में एक किशोर की आत्महत्या से जोड़ा गया था। परिवार का आरोप है कि इस प्लेटफॉर्म ने नाबालिगों में कई तरह की समस्याओं को बढ़ावा दिया है। वे आगे के नुकसान को रोकने के लिए तत्काल कार्रवाई की मांग कर रहे हैं।

ये भी पढ़ें : Redmi Note 14 सीरीज लॉन्च होते ही इन स्मार्टफोन्स की गिरी कीमत, लूट लो सस्ते में

टेक्नोलॉजी में समस्या नहीं हम कर रहे हैं गलत इस्तेमाल?

हालांकि इस खबर पर हमें ऐसा लगता है कि ये टेक्नोलॉजी में समस्या नहीं है बल्कि हम ही इसका गलत इस्तेमाल कर रहे हैं। अगर ओवरऑल देखा जाए तो चैटबॉट या AI खुद से कोई फैसला नहीं लेता है। यह सिर्फ वही फीडबैक देता है जो उसे डेटा और एल्गोरिदम के जरिए सिखाया गया है। इस केस में असली समस्या ये नहीं है कि AI ने गलत सजेशन दिया, बल्कि ये है कि एक किशोर ने अपनी पर्सनल और फैमिली प्रॉब्लम को सॉल्व करने के लिए एक चैटबॉट की मदद ली।

ये काम इस बात पर बड़ा सवाल उठाता है कि क्यों एक 17 साल के बच्चे ने अपने माता-पिता से बात करने या अपनी समस्या के लिए किसी दोस्त से बात करने के बजाय एक टेक्नोलॉजी का सहारा लिया। क्या ये फैमिली में लैक ऑफ कम्युनिकेशन (Lack of Communication) को नहीं दिखाता? क्या ये किशोरों के बढ़ते अकेलेपन और Digital Era में हमारे रिलेशनशिप के कमजोर होने का संकेत नहीं है?